1. QMIX 원본

https://arxiv.org/abs/1803.11485

QMIX: Monotonic Value Function Factorisation for Deep Multi-Agent Reinforcement Learning

In many real-world settings, a team of agents must coordinate their behaviour while acting in a decentralised way. At the same time, it is often possible to train the agents in a centralised fashion in a simulated or laboratory setting, where global state

arxiv.org

https://arxiv.org/abs/2003.08839

Monotonic Value Function Factorisation for Deep Multi-Agent Reinforcement Learning

In many real-world settings, a team of agents must coordinate its behaviour while acting in a decentralised fashion. At the same time, it is often possible to train the agents in a centralised fashion where global state information is available and communi

arxiv.org

2. Review

https://ropiens.tistory.com/112

QMIX: Monotonic Value Function Factorisation for Deep Multi-Agent Reinforcement Learning 리뷰

QMIX는 저번 COMA리뷰에 이은 2번째 멀티에이전트 강화학습에 대한 논문리뷰입니다. QMIX에 대해 공부할때는 크게 3가지 자료를 보시면 많이 도움이 되는데요, 1. 원 논문 arxiv.org/abs/1803.11485 QMIX: Monot

ropiens.tistory.com

https://leejungi.github.io/posts/QMIX/

(Rashid 2018 ICML) Qmix; Monotonic value function factorisation for deep multi-agent reinforcement learning

목차

leejungi.github.io

3. 정리

Multi Agent System Learning

- Competitive

- Cooperative

MAS chanllenge

- agent의 action을 모두 다루는 policy -> agent의 수에 비례해서 policy 크기가 exponetial하게 커짐

- agent가 항상 다른 모든 agent의 state와 action을 아는 것은 불가능함

-> 따라서, decentralized policy가 필요하게 됨

Decentralized policy

- Independent Q Learning, IQL

모든 agent가 각자의 policy와 action-value function에 따라서 greedy하게 action을 선택하면, 전체적으로도 optimal해진다.

쉽고 간단하다는 장점이 있지만, 특정 non-stationary case를 해결하지 못한다.

- Counterfactual multi-agent policy gradients, COMA

Qtot을 학습해서, 이를 가이드로 삼아 각 agent의 policy를 업데이트하는 방식(actor-critic)이다. 그러나 on-policy learning을 필요로하며, agents 수가 많아지면 centralized critic learning은 불가능해진다.

- Value Decomposing Network, VDN

IQN과 COMA를 섞은 방법이다. 모든 agent가 각자의 policy에 따라 greedy하게 행동하고 얻은 action-value function을 합쳐서 Qtot을 만든다. Qtot을 학습해서 policy를 수정하는 방법이다.

Centralized 하게 학습할 수 있지만, agent의 action이 Factored action-value function이다. 이때문에, centralized Qtot의 complexity표현이 제한적이라는 단점이 있다. 그리고 global state information을 이용하지 못하는 단점을 가지고 있다.

QMIX

VDN을 발전시킨, QMIX는 full factorization of VDN이 필요하지 않다. VDN의 성질을 가지고 가되, 한 가지 제한을 추가한다.

QMIX의 조건으로 세웠던 가정이다. VDN에서도 위 조건은 만족할 수 있다. QMIX는 이 가정을 한번 더 일반화시킨다.

만약 이 조건을 만족하도록 action을 선택한다면, 위의 조건을 만족한다.

QMIX architecture

Qtot은 agent network, mixing network, hypernetwork로 구성된다.

QMIX, agent network

DRQN을 이용한다. Current individual observation oat와 last action uat−1을 input으로 받아서 Qa(τa,uat)를 나타낸다.

QMIX, mixing network

Feed forward neural network로 구성되며 Hypernetwork를 이용한다. 각 hypernetwork는 st를 mixing network에서의 weight로 바꿔서 사용한다. Monotonicity constraint를 만족하기 위해서, 바뀌는 weight는 absolute activation function에 의해 non-negative로 제한한다. (Negative=0, by ReLU) 이렇게 함으로, mixing network가 어떤 monotonic function도 예측할 수 있게 된다.

st를 mixing network에 바로 사용하지 않는 이유는 Qtot이 non monotonic way에 있는 extra state information을 활용할 수 있기 때문에, monotonic network에 overly constraining일 수 있기 때문이다. 대신 hypernetwork를 사용함으로 s를 임의의 weight로 넘겨 flexible하게 사용할 수 있게 된다.

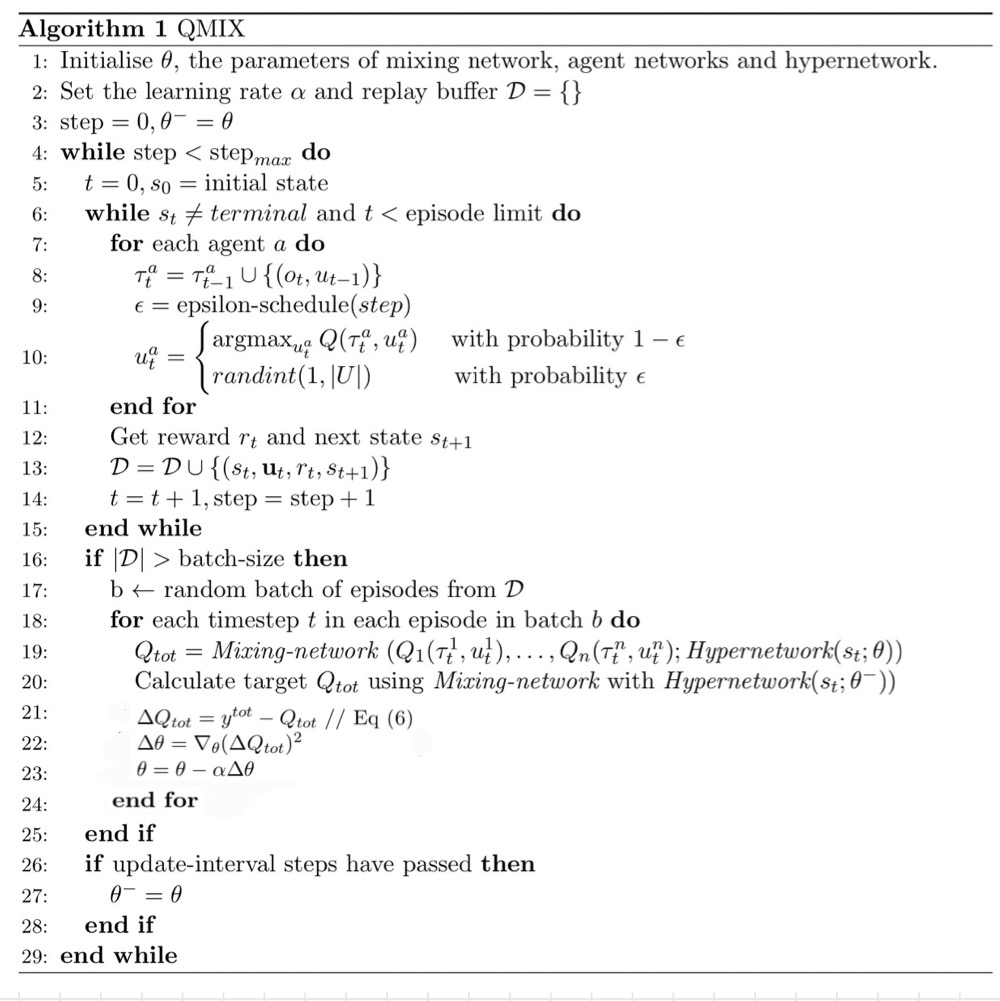

QMIX algorithm

4. Related work

[PAPER REVIEW] QTran: Learning to Factorize with Transformation

As explained by Kasim Te and Yajie Zhou.

www.kasimte.com

'Study > Reinforcement Learning' 카테고리의 다른 글

| 4. Monte Carlo Methods and Temporal Difference Learning in Policy Evaluation (0) | 2023.05.01 |

|---|---|

| 3. Policy Improvement by Iterative Method (0) | 2023.05.01 |

| 2. Bellman equation and MDP (0) | 2023.05.01 |

| 1.Introduction (0) | 2023.05.01 |